BIODAS Team hân hạnh chia sẻ đến bạn đọc công trình vừa được công bố từ Trường Y Harvard (Harvard Medical School) — một cột mốc quan trọng trong lịch sử trí tuệ nhân tạo y học: “Advancing Medical Artificial Intelligence Using a Century of Cases” (Buckley TA, Conci R, Brodeur PG, et al., 2025).

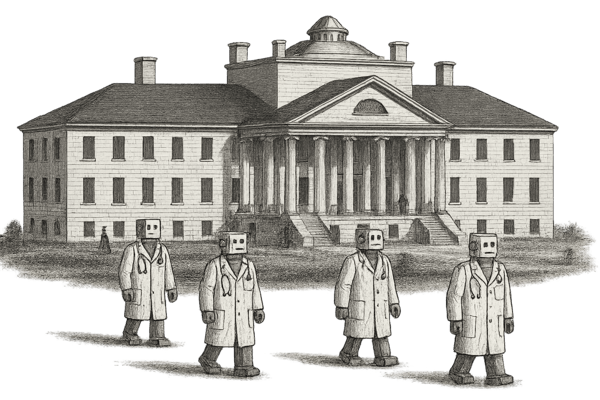

Lần đầu tiên trong gần 200 năm lịch sử của New England Journal of Medicine (NEJM), một chẩn đoán do AI tạo ra đã được công bố song song với chẩn đoán của bác sĩ con người. Hệ thống AI này mang tên Dr. CaBot – “bác sĩ ảo” được huấn luyện trên hơn 7.102 ca bệnh thực tế được NEJM xuất bản suốt một thế kỷ (1923–2025).

Công trình do Thomas Buckley và Arjun K. Manrai dẫn dắt, thuộc Manrai Lab, Khoa Tin sinh học Y học, Harvard Medical School, phối hợp với Beth Israel Deaconess Medical Center và Massachusetts General Hospital. Nghiên cứu đồng thời giới thiệu CPC-Bench – bộ chuẩn đầu tiên trên thế giới để đánh giá năng lực lập luận, chẩn đoán và giải thích của mô hình AI y học.

1. Điểm nhấn nổi bật của nghiên cứu

- NEJM lần đầu tiên công bố một chẩn đoán do AI tạo ra – Dr. CaBot trình bày song song với bác sĩ thật.

- Dr. CaBot có thể phân tích, lập luận và thuyết trình lâm sàng theo phong cách hội chẩn CPCs.

- CPC-Bench bao gồm 7.102 ca bệnh CPC và 1.021 NEJM Image Challenges, xác thực bởi bác sĩ.

- OpenAI o3 đạt độ chính xác chẩn đoán top-1 = 60%, top-10 = 84%, vượt 20 bác sĩ nội khoa (24% và 45%).

- Trong thử nghiệm mù, 74% bác sĩ nhầm Dr. CaBot là người thật – AI được đánh giá cao hơn về chất lượng lập luận.

- Toàn bộ dự án được công khai tại: https://cpcbench.com

3. Đặt vấn đề

Trí tuệ nhân tạo (AI) đang thay đổi cách tiếp cận chẩn đoán và ra quyết định lâm sàng. Tuy nhiên, phần lớn các mô hình chỉ được đánh giá dựa trên độ chính xác đầu ra, trong khi lý luận lâm sàng – quá trình phân tích và suy luận dẫn đến chẩn đoán – mới là giá trị cốt lõi của y học.

Các hội chẩn Clinicopathological Conferences (CPCs), do bác sĩ Richard Cabot khởi xướng năm 1923 tại Bệnh viện Đa khoa Massachusetts (MGH), là nơi các chuyên gia trình bày, lập luận và bảo vệ chẩn đoán dựa trên dữ kiện ca bệnh thực tế. Sau một thế kỷ, NEJM đã xuất bản hơn 7.000 ca CPC – một kho dữ liệu vô giá mô tả cách con người tư duy trong y học. Nhóm Harvard nhận thấy đây chính là nền tảng để xây dựng thế hệ AI biết lý luận như bác sĩ thật.

4. Phương pháp nghiên cứu

- Thu thập 7.102 ca CPC (1923–2025) và 1.021 NEJM Image Challenges (2006–2025).

- Xây dựng CPC-Bench – bộ chuẩn gồm 10 nhiệm vụ y học (chẩn đoán, xét nghiệm, tìm tài liệu, hình ảnh...).

- Dữ liệu được chú giải và xác thực bởi 10 bác sĩ nội khoa (5 nội trú, 5 bác sĩ điều trị).

- Phát triển hệ thống Dr. CaBot dựa trên mô hình OpenAI o3, có khả năng tìm các ca tương tự, mô phỏng phong cách viết của chuyên gia CPC, và sinh video hội chẩn bằng LaTeX Beamer + TTS-HD.

- So sánh với 20 bác sĩ nội khoa và tiến hành thử nghiệm “mù” để đánh giá độ giống con người của AI.

5. Kết quả nổi bật

OpenAI o3 đạt Top-1 = 60%, Top-10 = 84%, vượt xa nhóm bác sĩ (24% và 45%). Độ chính xác chọn xét nghiệm hợp lý đạt tới 98%. Trong thử nghiệm “mù”, 74% bác sĩ nhầm lẫn AI với con người – và thậm chí đánh giá Dr. CaBot cao hơn về lập luận và hấp dẫn học tập.

Ở mảng hình ảnh, Gemini 2.5 Pro đạt 84%, o3 đạt 82%, GPT-4o đạt 75%. Tuy nhiên, AI vẫn yếu ở X-quang và mô bệnh học (55–67%). Khi phân tích lịch sử CPC suốt 100 năm, nhóm phát hiện sự chuyển dịch bệnh học: từ 56% bệnh nhiễm trùng (1920s) sang 68% ung thư (1950s), và Dr. CaBot đạt hiệu suất tương đương – thậm chí vượt nhẹ chuyên gia người ở giai đoạn 2000–2010.

6. Bàn luận

Kết quả cho thấy mô hình ngôn ngữ lớn (LLMs) không chỉ tái hiện thông tin mà còn tái hiện được tư duy y học. CPC-Bench trở thành thước đo chuẩn hóa, giúp cộng đồng khoa học theo dõi tiến bộ của AI trong chẩn đoán lâm sàng.

Dr. CaBot hứa hẹn trở thành công cụ giảng dạy mạnh mẽ trong đào tạo y khoa, khi người học có thể thảo luận trực tiếp với AI, học cách đặt giả thuyết và suy luận đa tầng. Tuy nhiên, nhóm Harvard lưu ý rằng AI vẫn cần cải thiện khả năng tra cứu tài liệu, xử lý hình ảnh và tuân thủ các tiêu chuẩn đạo đức – bảo mật dữ liệu bệnh nhân.

7. Kết luận

Từ bác sĩ Richard Cabot của thế kỷ XX đến Dr. CaBot của thế kỷ XXI, hành trình một thế kỷ của các hội chẩn CPC đã khép lại vòng tròn giữa con người và trí tuệ nhân tạo. Dr. CaBot chứng minh rằng AI không chỉ đưa ra đáp án, mà còn hiểu và giải thích được tư duy lâm sàng – nền tảng của nghề y.

“Dr. CaBot không thay thế bác sĩ, mà minh chứng cho sự hợp tác giữa con người và máy móc trong hành trình tìm hiểu y học.” — Nhóm nghiên cứu Harvard Medical School

Tài liệu tham khảo

- Buckley T.A. et al. (2025). Advancing Medical Artificial Intelligence Using a Century of Cases. arXiv:2509.12194. https://doi.org/10.48550/arXiv.2509.12194

- Brinkmann R. et al. (2024). Building a Community of Medical Learning – A Century of Case Records of the MGH in the Journal. N Engl J Med, 391(9):858–863.

- Kanjee Z. et al. (2023). Accuracy of a Generative AI Model in a Complex Diagnostic Challenge. JAMA, 330(1):78–80.

- McDuff D. et al. (2025). Towards Accurate Differential Diagnosis with Large Language Models. Nature, 642(8067):451–457.

- Rodman A. et al. (2025). When it Comes to Benchmarks, Humans Are the Only Way. NEJM AI, 2(4):AIe2500143.

- Priem J. et al. (2022). OpenAlex: A Fully Open Index of Scholarly Works. arXiv [cs.DL]:2205.01833.

- Diao J.A., Adamson A.S. (2022). Representation and Misdiagnosis of Dark Skin in a Large-Scale Visual Diagnostic Challenge. J Am Acad Dermatol, 86(4):950–951.