1. Giới thiệu

Bài tổng quan “Considering Biased Data as Informative Artifacts in AI-Assisted Health Care” của Kadija Ferryman (Johns Hopkins University), Maxine Mackintosh (Genomics England) và Marzyeh Ghassemi (MIT), được đăng trên The New England Journal of Medicine (2023), đã đặt ra một góc nhìn mới mẻ về dữ liệu y tế trong kỷ nguyên trí tuệ nhân tạo (AI).

Thay vì xem dữ liệu bị thiên lệch như “rác thải kỹ thuật” cần loại bỏ theo quan niệm “garbage in – garbage out”, nhóm tác giả cho rằng chính những sai lệch này là “những tạo tác giàu thông tin” (informative artifacts) — phản chiếu giá trị, tập quán và bất bình đẳng đã ăn sâu trong hệ thống y tế hiện đại. Việc xem dữ liệu như những “di chỉ xã hội” có thể giúp chúng ta hiểu rõ hơn về cách công nghệ phản ánh và đôi khi khuếch đại bất công trong chăm sóc sức khỏe.

Quan điểm này gợi ý rằng, thay vì chỉ cố gắng “sửa lỗi” trong dữ liệu, giới khoa học cần học cách “đọc hiểu” chúng — như cách các nhà khảo cổ học diễn giải những cổ vật để hiểu về xã hội thời xưa. Dữ liệu lâm sàng, nếu được nhìn nhận như một loại “tạo tác”, có thể tiết lộ nhiều điều về tổ chức bệnh viện, văn hóa nghề nghiệp, và cách xã hội đánh giá sức khỏe và giá trị con người.

BIODAS Team giới thiệu tổng quan này nhằm khuyến khích tư duy phản biện về cách dữ liệu và thuật toán định hình công bằng y tế. Khi hiểu rõ nguồn gốc của thiên lệch, chúng ta có thể chuyển hóa AI từ công cụ dự đoán sang công cụ phát hiện bất bình đẳng sức khỏe.

2. Đặt vấn đề

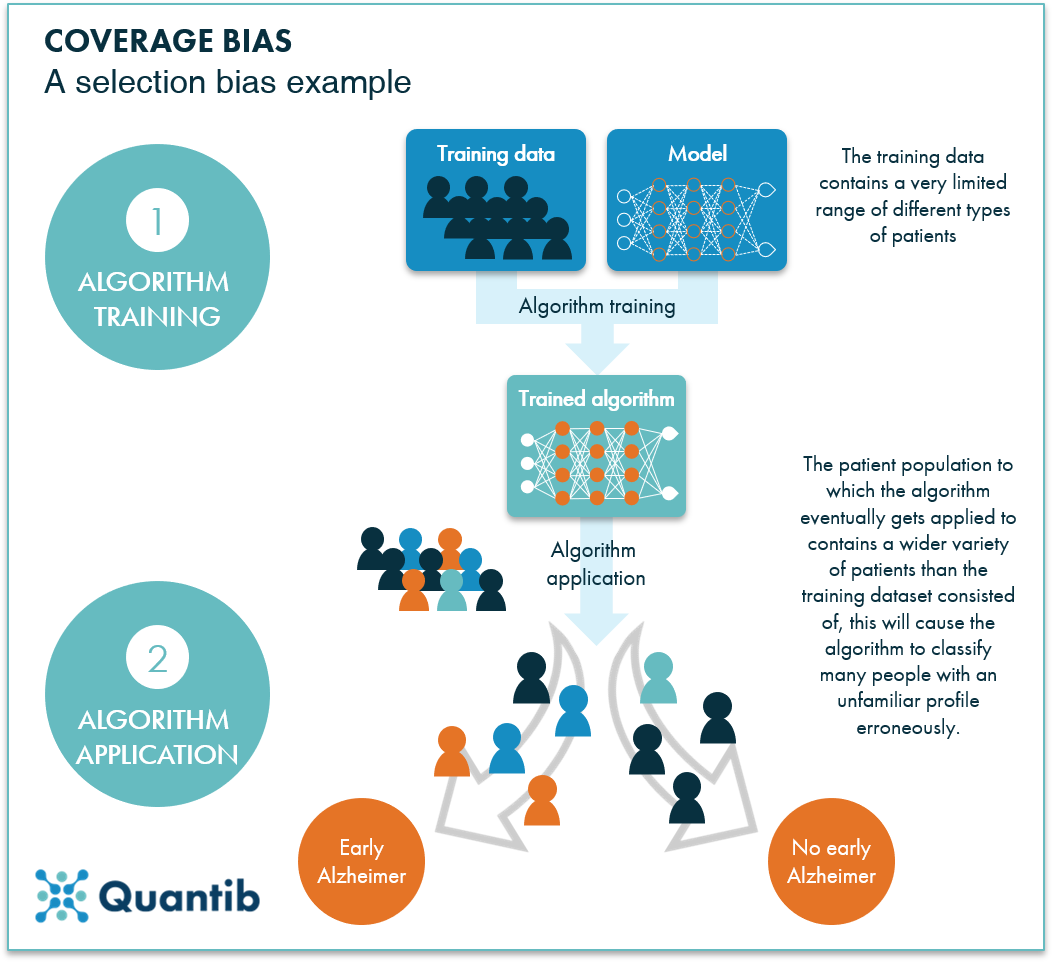

Trong chăm sóc sức khỏe hiện đại, các hệ thống AI phụ thuộc gần như hoàn toàn vào những tập dữ liệu khổng lồ đã được gán nhãn. Khi những dữ liệu này phản ánh sự khác biệt về chủng tộc, giới tính, hoặc điều kiện kinh tế – xã hội, AI có thể vô tình tái tạo các định kiến xã hội — hiện tượng được gọi là phân biệt đối xử thuật toán (algorithmic discrimination).

Ví dụ, trong một nghiên cứu về X-quang ngực, hệ thống AI được huấn luyện bằng hàng nghìn hình ảnh vẫn thể hiện xu hướng chẩn đoán thiếu (underdiagnosis) ở nhóm bệnh nhân da đen và người gốc Mỹ Latin, đặc biệt là phụ nữ. Điều này xảy ra bởi vì dữ liệu ban đầu vốn đã không phản ánh công bằng tình hình bệnh lý của các nhóm dân số.

Theo Ferryman và cộng sự, vấn đề không chỉ nằm ở dữ liệu “bị sai” mà còn ở cách chúng ta hiểu dữ liệu. Dữ liệu lâm sàng là sản phẩm của bối cảnh xã hội, quy trình tổ chức và quyết định chuyên môn; vì vậy, mỗi “thiên lệch” là một chỉ dấu của văn hóa và lịch sử ngành y. Thay vì loại bỏ, chúng ta có thể học từ những thiên lệch đó để cải thiện công bằng sức khỏe.

3. Ba khía cạnh chính: Khi dữ liệu trở thành “tạo tác”

3.1. Dữ liệu và giá trị xã hội

“Hiệu chỉnh chủng tộc” trong ước tính chức năng thận (eGFR) từng được xem là cải tiến khoa học, nhưng thực chất phản ánh giả định rằng người da đen có khối cơ cao hơn – một di sản từ thời cơ thể nam giới da trắng được xem là “chuẩn mực sinh học”. Khi những công thức này được đưa vào AI, chúng tiếp tục tái sản xuất định kiến chủng tộc dưới lớp vỏ trung lập của thuật toán.

Nhìn từ góc độ “tạo tác”, việc tồn tại các biến số “race correction” không chỉ là lỗi thống kê, mà là dấu vết của một giai đoạn lịch sử khi khoa học y học được xây dựng trên nền tảng phân biệt chủng tộc. Thừa nhận và phân tích nguồn gốc của các “giá trị ẩn” này chính là bước đầu tiên để hướng tới AI y tế có trách nhiệm hơn.

3.2. Dữ liệu và thực hành lâm sàng

Nhiều bệnh án điện tử thiếu dữ liệu về bản dạng giới, tình trạng khuyết tật hoặc yếu tố xã hội. Sự “thiếu vắng dữ liệu” này không đơn thuần là lỗi kỹ thuật, mà phản ánh sự thiếu đồng nhất trong ngôn ngữ y học, rào cản niềm tin giữa bác sĩ và bệnh nhân, cũng như hạn chế trong đào tạo nhân viên y tế về đa dạng giới. Theo nhóm tác giả, nếu tiếp cận theo hướng “tạo tác”, chúng ta có thể dùng AI để nhận diện nơi nào dữ liệu bị thiếu, từ đó khơi mở các câu hỏi về công bằng và đại diện trong y tế.

AI, khi được sử dụng đúng cách, có thể phát hiện những “khoảng trống dữ liệu” — chẳng hạn như việc thiếu dữ liệu của nhóm dân tộc thiểu số hoặc bệnh nhân LGBTQ+ — và biến chúng thành tín hiệu để nghiên cứu sâu hơn về bất bình đẳng hệ thống.

3.3. Dữ liệu và bất bình đẳng sức khỏe

Trong lĩnh vực ung thư phổi, dữ liệu cho thấy bệnh nhân da đen thường được chẩn đoán muộn hơn người da trắng, khiến AI “học” rằng nhóm này có tiên lượng xấu hơn. Nếu không xem xét bối cảnh xã hội, mô hình AI sẽ củng cố chính những bất công mà nó nên khắc phục. Khi coi dữ liệu như tạo tác, nhà nghiên cứu có thể phát hiện và làm sáng tỏ những chuỗi loại trừ mang tính hệ thống trong y tế, chẳng hạn như sự thiếu tiếp cận dịch vụ sàng lọc sớm, chi phí điều trị cao, hoặc định kiến trong quy trình phân loại bệnh.

“Dữ liệu y tế không chỉ nói về bệnh nhân – chúng nói về toàn bộ hệ thống chăm sóc và những gì xã hội coi trọng.”

4. Hướng tiếp cận xã hội – kỹ thuật (sociotechnical)

Ferryman và cộng sự đề xuất một khung phân tích kết hợp giữa công nghệ, đạo đức và xã hội, nhằm mở rộng cách hiểu về thiên lệch dữ liệu. Thay vì chỉ “vá lỗi” kỹ thuật, họ đề nghị một cách tiếp cận toàn diện hơn, kết hợp dữ liệu, con người và bối cảnh xã hội.

- Vượt qua “làm sạch dữ liệu”: Không chỉ loại bỏ sai lệch mà cần diễn giải nguyên nhân xã hội – lịch sử đằng sau dữ liệu đó.

- Hợp tác liên ngành: Kết nối bác sĩ, kỹ sư, nhà đạo đức học, và nhà xã hội học để đồng kiến tạo giải pháp.

- Đồng bộ với công bằng sức khỏe: Xem AI không chỉ là công cụ phát hiện bệnh, mà là công cụ phát hiện bất bình đẳng.

Cách tiếp cận này đưa AI ra khỏi phạm vi “công nghệ thuần túy”, hướng tới một mô hình phát triển mang tính phản tư và nhân văn hơn. Nó cũng mở ra cơ hội sử dụng AI như công cụ xã hội học để soi chiếu chính các cấu trúc bất công mà dữ liệu phản ánh.

5. Ứng dụng tại Việt Nam

Trong bối cảnh Việt Nam đang xây dựng hạ tầng dữ liệu y tế quốc gia và triển khai bệnh án điện tử, tư duy “dữ liệu như tạo tác” đặc biệt có ý nghĩa:

- Giúp đánh giá thiên lệch tiềm ẩn trong dữ liệu y tế, từ vùng miền đến giới tính và điều kiện kinh tế.

- Đặt nền tảng cho khung đạo đức dữ liệu và chính sách minh bạch khi ứng dụng AI trong y tế công.

- Khuyến khích hợp tác giữa y học, khoa học dữ liệu và khoa học xã hội để đảm bảo công bằng sức khỏe.

Các dự án quốc gia như hồ sơ sức khỏe điện tử, dữ liệu tiêm chủng, hoặc hệ thống dự báo dịch bệnh cần được thiết kế với ý thức xã hội – kỹ thuật này. Việc lưu ý đến thiên lệch dữ liệu (ví dụ: bệnh nhân vùng sâu, dân tộc thiểu số ít được ghi nhận) có thể giúp ngăn ngừa việc tái tạo bất bình đẳng trong y tế số.

Nhận diện thiên lệch không phải để loại bỏ dữ liệu, mà để hiểu sâu hơn về chính hệ thống đã sinh ra dữ liệu đó — từ đó kiến tạo công bằng y tế bền vững.

6. Kết luận

“Thiên lệch dữ liệu” không chỉ là lỗi kỹ thuật – nó là tấm gương phản chiếu lịch sử, văn hóa và cấu trúc xã hội. Khi xem dữ liệu như “tạo tác thông tin”, chúng ta có thể dùng AI để soi chiếu những bất bình đẳng tiềm ẩn, thay vì vô tình củng cố chúng.

Đây chính là bước chuyển từ “AI chính xác” sang “AI công bằng” — một hướng đi cần thiết để đảm bảo rằng tiến bộ công nghệ luôn gắn liền với nhân văn và công lý trong y học số. Như Ferryman và đồng nghiệp kết luận, “một hệ thống AI y tế chỉ thực sự thông minh khi nó hiểu rõ lịch sử và giá trị con người ẩn trong dữ liệu mà nó học từ đó.”

7. Tài liệu tham khảo

- Ferryman K, Mackintosh M, Ghassemi M. Considering Biased Data as Informative Artifacts in AI-Assisted Health Care. N Engl J Med. 2023;389(9):833–838. DOI: 10.1056/NEJMra2214964.

- Obermeyer Z, Powers B, Vogeli C, Mullainathan S. Dissecting racial bias in an algorithm used to manage the health of populations. Science. 2019;366:447–453.

- Inker LA et al. New creatinine- and cystatin C–based equations to estimate GFR without race. N Engl J Med. 2021;385:1737–1749.

- Chen IY, Joshi S, Ghassemi M. Treating health disparities with artificial intelligence. Nat Med. 2020;26:16–17.